Robots.txt

Hinter der Bezeichnung robots.txt steckt eine Datei, die in der oberen Verzeichnisebene einer Webseite hinterlegt wird, um die Webcrawler von Suchmaschinen wie Google, Yahoo und Bing für bestimmte Bereiche auszuschließen. Das bedeutet: Trifft ein Bot bzw. Crawler auf eine Domain, wird er zuerst die robots.txt Datei im Stammverzeichnis (root) lesen und folglich erkennen, welche weiteren Verzeichnisse und Teilbereiche der Webseite zu crawlen sind und welche nicht. Es können auch Bereiche einzelner Seiten ausgeschlossen werden – beispielsweise Anzeigen. Die Datei kann also als eine Art Anleitung für Bots verstanden werden, in dem sie nachlesen können, was sie auf einer Site im Web tun dürfen und was nicht.

Wo soll die robots.txt abgelegt werden?

Die Datei sollte sich im Hauptverzeichnis einer Website befinden, damit Suchmaschinen diese finden können. Woanders wird diese nicht gefunden. Pro Hauptdomain kann es außerdem nur eine robots.txt Datei geben.

Aufbau einer robots.txt Datei

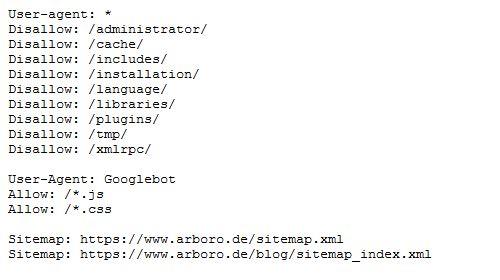

Eine solche Datei besteht immer aus zwei Teilen. Der erste Teil spricht den User-agent an. Danach kommt der Befehl durch die Anweisung “allow” oder “disallow” mit dem Verzeichnis, das von den Bots ausgeschlossen oder eben gelesen werden soll.

Der User-agent spricht die Suchmaschinen-Bots an. Hierbei können mit einem Asterisk (*) alle Bots angesprochen werden. Man kann aber auch entscheiden, dass zum Beispiel der Google Bot ein Verzeichnis crawlen darf, das wiederum der Bing Bot nicht lesen darf. So werden die jeweiligen Bots der angesprochen:

| Suchmaschine | Bot |

| Googlebot | |

| Bing | Bingbot |

| Yahoo | Slurp |

| MSN | Msnbot |

Mit dem Befehl allow: / zeigt man dem Bot an, dass das Verzeichnis gecrawlt werden kann.

Mit disallow: / hingegen werden Verzeichnisse ausgeschlossen.

Beispiel 1:

User-agent: Googlebot

Disallow: /Verzeichnis2/

So sagen wir dem Google Crawler, dass er das Verzeichnis 2 nicht auslesen darf.

Beispiel 2:

User-agent: *

Allow: /

Mit diesem Hinweis sagen wir in der robots.txt Datei, dass alle Webcrawler ausnahmslos auf alle Unterverzeichnisse zugreifen können.

Wichtig erscheint dieser Ausschluss unter anderem für Unterseiten, die sich noch im Aufbau befinden. Die Einrichtung einer Robots.txt Datei ist keine Garantie für den Ausschluss der gekennzeichneten Seite. Das liegt unter anderem daran, dass der Bot auch über Verlinkungen auf eine Seite gelangen kann und diese dann indexiert, obwohl sie im Stammverzeichnis der Domain von der Indexierung ausgeschlossen wurde. Der konsequente Ausschluss von Webseiten und Unterverzeichnissen muss mit anderen Methoden wie der HTTP-Authentifizierung erfolgen.

Auch vor Angriffen durch Dritte ist man mit einer robots.txt Datei nicht direkt geschützt. Dafür sollte auch ein passwortgeschützter Zugriff in Betracht gezogen werden.

Die Sitemap kann in der robots.txt hinterlegt werden, sodass man sicher sein kann, dass der Crawler diese erreicht. Dies hilft auch bei der Indexierung von Unterseiten.

Was steckt hinter der Robots.txt Datei?

Hinter Robots.txt steckt eine unabhängige Gemeinschaft, die 1994 den Robots Exclusion Standard entwickelte. In 2008 haben sich einige Suchmaschinen wie Google, Microsoft und Yahoo dazu bereit erklärt, einige Aspekte des Webcrawlings einheitlich zu gestalten, so dass das Robots Exclusion Standard heute tatsächlich als Standard gilt. In der Textdatei werden die Anweisungen für den Bot durch zwei Bereiche markiert, die von einem Doppelpunkt getrennt werden. Durch die Bezeichnung „User-agent“ wird der entsprechende Bot (beispielsweise von Google) auf seine Aufgabe aufmerksam gemacht, die in der zweiten Zeile durch ein „allow“ oder „disallow“ mit dem jeweiligen Seitenbereich beschrieben wird. Da dem Webcrawler für gewöhnlich erlaubt wird, die Seiten zu indexieren, arbeitet man hauptsächlich mit dem Attribut „disallow“.

Wie erstellt man eine solche Datei?

Bei der Erstellung einer robots.txt Datei greift man in der Regel auf einen einfachen Editor zurück. Alternativ gibt es auch Online-Tools, die bei der Erstellung behilflich sind. Wichtig ist, dass auf die Groß- und Kleinschreibweise geachtet wird. So wird robots.txt streng genommen immer kleingeschrieben. Grundsätzlich muss jeder Bot einzeln angewiesen werden. Das bedeutet, man muss Anweisungen für den Googlebot (Websuche), den Bot der Google News und Shopping sowie der anderen Suchmaschinenanbieter verfassen. Bestimmte Bezeichnungen und Befehle helfen bei der Umsetzung der Robots.txt.